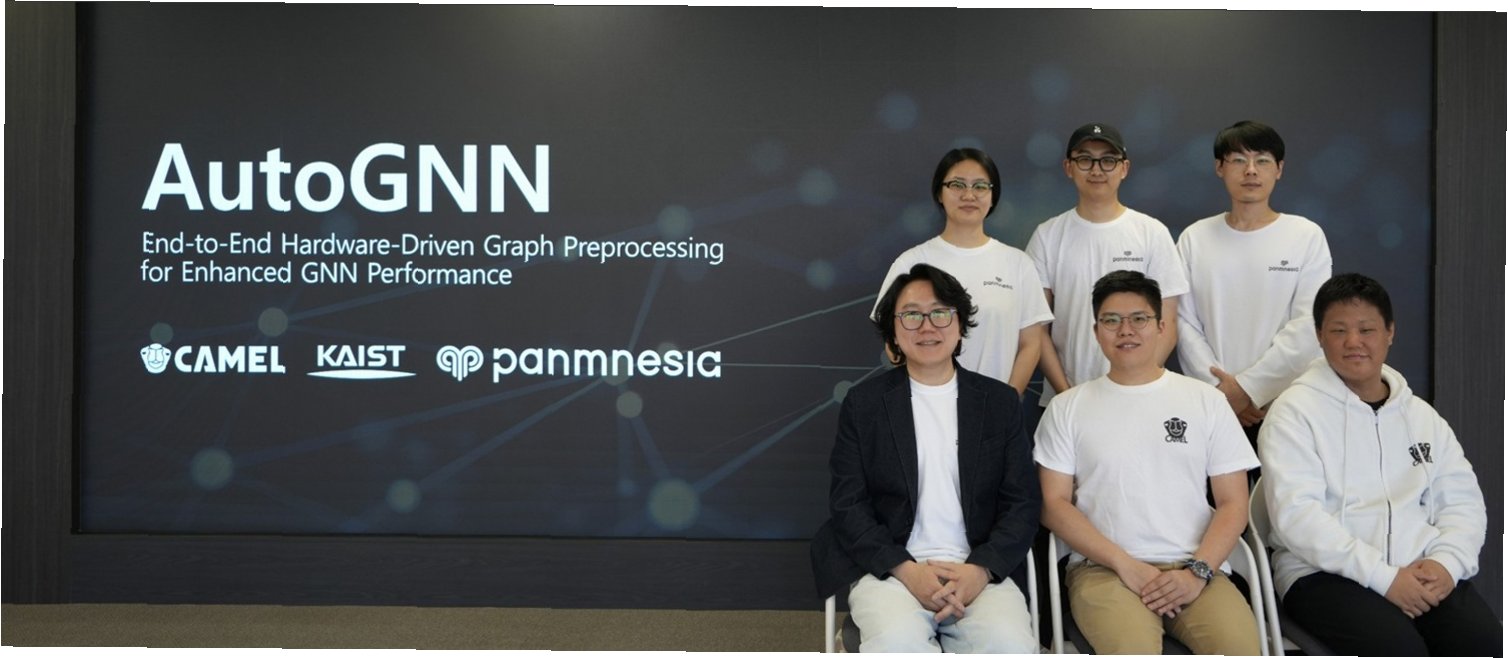

국내 연구진, AI 추론 속도 2.1배 높인 '오토GNN' 개발

국내 연구진이 엔비디아보다 2.1배 빠른 AI 반도체 기술 '오토GNN'을 개발하며 기술력을 입증했습니다. 이 기술은 그래프 신경망(GNN) 기반 AI 추론 과정에서 발생하는 병목 현상을 획기적으로 개선하여 속도를 높인 것이 특징입니다. KAIST 정명수 교수 연구팀은 유튜브 추천, 금융 사기 탐지 등 복잡한 관계 분석이 필요한 AI 서비스의 성능을 크게 향상시킬 수 있는 기반을 마련했습니다.

그래프 전처리 병목 현상, '적응형 AI 가속기'로 해결

기존 AI 반도체는 복잡한 관계 구조를 처리하는 데 한계가 있어, 전체 계산 시간의 70~90%를 차지하는 그래프 전처리 단계에서 병목 현상이 발생했습니다. 오토GNN은 이러한 문제를 해결하기 위해 입력 데이터 구조에 따라 반도체 내부 회로를 실시간으로 변경하는 '적응형 AI 가속기' 기술을 도입했습니다. 이를 통해 데이터 연결 방식에 맞춰 최적의 회로 구조를 스스로 찾아내어 효율성을 극대화합니다.

실시간 최적화 모듈로 안정적인 고성능 구현

오토GNN은 필요한 데이터만 선별하는 UPE 모듈과 이를 빠르게 집계하는 SCR 모듈을 반도체 내부에 구현했습니다. 데이터의 양이나 형태가 변해도 최적의 모듈 구성이 자동으로 적용되어, 어떤 상황에서도 안정적인 고성능을 유지할 수 있습니다. 이러한 기술적 진보는 AI 서비스의 속도와 에너지 효율을 동시에 높이는 데 기여할 것으로 기대됩니다.

엔비디아 GPU 대비 월등한 성능 및 효율성 입증

성능 평가 결과, 오토GNN은 엔비디아의 고성능 GPU(RTX 3090)보다 2.1배 빠른 처리 속도를 기록했으며, 일반 CPU 대비해서는 9배 빠른 성능을 보였습니다. 또한, 에너지 소모는 3.3배 줄여 뛰어난 효율성까지 확보했습니다. 이러한 결과는 추천 시스템, 금융 사기 탐지 등 실시간 분석이 필수적인 다양한 AI 분야에 즉시 적용 가능함을 시사합니다.

AI 반도체, 국산 기술로 한 단계 도약하다

KAIST 연구진이 개발한 '오토GNN'은 엔비디아를 능가하는 AI 추론 속도와 에너지 효율성을 자랑합니다. 데이터 구조에 따라 스스로 최적화되는 혁신적인 기술로, 복잡한 관계 분석이 필요한 AI 서비스의 미래를 밝게 하고 있습니다.

오토GNN, 무엇이 궁금하신가요?

Q.오토GNN의 핵심 기술은 무엇인가요?

A.입력 데이터 구조에 따라 반도체 내부 회로를 실시간으로 변경하는 '적응형 AI 가속기' 기술과 UPE, SCR 모듈을 통해 데이터 처리 효율을 극대화합니다.

Q.기존 GPU 대비 성능 향상 정도는 어느 정도인가요?

A.엔비디아 고성능 GPU 대비 2.1배 빠른 처리 속도를 기록했으며, 일반 CPU보다는 9배 빠릅니다.

Q.어떤 AI 서비스에 적용될 수 있나요?

A.유튜브 추천, 금융 사기 탐지 등 복잡한 관계 분석과 빠른 응답이 필요한 실시간 AI 서비스에 즉시 적용 가능합니다.

'이슈' 카테고리의 다른 글

| 인구 소멸 위기, '외국인 처녀 수입' 발언에 광주시장 '화들짝'…대안은? (0) | 2026.02.05 |

|---|---|

| 가세연, 박근혜 전 대통령 대구 사저 가압류…10억 대여금 미변제 논란 (0) | 2026.02.05 |

| 팔고 싶어도 못 파는 집, 부동산 3중 규제의 역설 (0) | 2026.02.05 |

| 박영재 법원행정처장, '이재명 판결' 옹호와 사법개혁 반대 입장 밝혀 (0) | 2026.02.05 |

| 가덕신공항, 대우건설의 자신감으로 연약지반 난관 극복할까? (0) | 2026.02.05 |